Can Artificial Intelligence Trade the Stock Market?

创建于 更新于

摘要

本论文系统研究了Deep Reinforcement Learning(DRL)在股票市场及多资产交易中的应用效果,比较了DDQN与PPO两种算法结合神经网络和Transformer架构在不同市场环境下的表现。结果表明,PPO结合Transformer表现最佳,在多资产与时间周期均优于传统买入持有及完美年化策略,且能有效规避风险,展示了DRL在量化交易中的巨大潜力与可行性[page::0][page::30][page::47][page::53].

速读内容

DRL算法及架构介绍 [page::3][page::8][page::16]

- 研究聚焦DDQN和PPO两种深度强化学习算法,分别采用全连接神经网络(NN)与Transformer网络作为策略近似函数。

- 解释了强化学习基本概念、Temporal Difference(TD)、Generalized Advantage Estimation(GAE)等关键技术。

- PPO采用剪切机制和GAE提升稳定性,DDQN侧重价值函数估计减少过估计偏差。

研究设计与评估框架 [page::24][page::27]

- 选取EUR/USD、EUR/JPY、USD/JPY三大主流货币对,S&P 500指数与比特币作为测试标的。

- 应用滚动窗口的前向优化策略,确保结果稳健性。

- 主要评价指标包括CAGR、年化夏普率、索提诺比率以及最大回撤等风险调整后绩效度量。

- 强调通过策略的数量化行为模式分析交易频率、持仓时间和交易胜率等。

量化策略表现总结与资产比较 [page::32][page::47]

- PPO结合Transformer(PPOT)策略在几乎所有资产上表现最佳,夏普比率居领先;

- DDQN结合Transformer(DDQNT)策略次之,表现稳健;

- 在FOREX市场,DRL策略能有效捕获短期趋势,避开风险区域,表现优于买入持有和完美年化策略;

- S&P 500指数上,DDQNT在疫情暴跌期取得突出收益,PPOT风险管理能力更优;

- 比特币市场中,PPOT实现最佳收益,但未超越完美策略,训练数据不足为其限制;

关键量化策略性能指标(以EUR/USD为例) [page::32]

| 策略 | 最终资金 | CAGR | 年化波动率 | 夏普率 | 索提诺率 | 最大回撤 | 交易次数 | 平均持仓天数 | 多头占比 | 空头占比 | 观望占比 |

|----------|---------|--------|------------|---------|----------|-----------|---------|--------------|----------|----------|----------|

| DDQNNN | 14,444.74 | 7.63% | 4.14% | 1.842 | 2.043 | -4.40% | 167 | 2.28 | 58.6% | 17.7% | 26.2% |

| DDQNT | 12,512.91 | 4.58% | 4.43% | 1.035 | 0.853 | -11.30% | 392 | 2.56 | 55.4% | 2.5% | 30.7% |

| PPONN | 10,360.83 | 0.71% | 6.53% | 0.108 | 0.136 | -14.70% | 703 | 2.45 | 50.3% | 49.5% | 30.1% |

| PPOT | 13,271.26 | 5.82% | 6.86% | 0.847 | 1.197 | -11.60% | 394 | 2.45 | 48.5% | 40.4% | 45.6% |

| 完美策略 | 13,150.82 | 6.61% | 7.07% | 0.935 | 1.396 | -9.20% | — | 392 | 60% | 40% | 0% |

| 买入持有 | 9,641.81 | -0.84%| 7.84% | -0.108 | -0.159 | -22.50% | — | 1557 | 100% | 0% | 0% |

- 其中DDQN

量化策略行为特征总结 [page::29]

- DRL策略具备主动避险特性,大幅时间观察市场而非强制交易,规避极端行情风险,提升风险调整后收益。

- 策略胜率不一定高,典型如比特币中部分策略胜率低但仍获利,体现对行情区间的精准把控及仓位策略。

- PPO策略表现优于DDQN,Transformer架构显著优于传统全连接神经网络。

研究讨论与未来工作展望 [page::49][page::51][page::52]

- 明确指出时序差分方法、策略型模型决策的随机性及策略学习假设对市场环境影响有限是应用中的主要挑战。

- 强调DRL在风险控制上的显著优势,尤其是通过非交易策略避免损失,可能挑战传统有效市场假说。

- 未来方向建议:位置规模动态调整、层级强化学习(HRL)、超参数优化以提升策略稳定性和实用性。

深度阅读

金融研究报告详尽分析报告

报告标题:Can Artificial Intelligence Trade the Stock Market?

作者:Jędrzej Maskiewicz、Paweł Sakowski

机构:Quantitative Finance Research Group,华沙大学经济科学系

发布日期:未标明确切日期,研究期涵盖2019-2023年数据

主题:基于深度强化学习(DRL)技术在股市及多类资产(外汇、股指、加密货币)中的应用及效果评估

---

1. 元数据与概览

本报告通过实证研究探索深度强化学习(DRL)算法能否有效交易股票市场。核心研究围绕两大DRL算法:Double Deep Q-Network(DDQN)和Proximal Policy Optimisation(PPO),并对比传统买入持有(Buy and Hold)策略。研究选择了三对主要外汇货币对(EUR/USD,EUR/JPY,USD/JPY)、美国标普500指数(S&P 500)及比特币(Bitcoin)作为测试资产,基于2019至2023年每日数据进行回测。

报告主题聚焦于DRL在复杂市场环境中的风险管理能力,及其在不同资产类别上的表现差异。主要结论是:DRL尤其是结合先进神经网络(Transformer)的PPO算法展现出较传统方法更优的风险调整收益表现,且能通过有策略的回避操作规避不利市场状态,实现风险管理优势。报告未单独给出明确买入卖出评级或目标价,重点是验证DRL模型在多资产、多市场条件下的有效性和稳定性。

关键词包括强化学习、深度学习、算法交易、DDQN、PPO等,理论基础涵盖强化学习核心原理、神经网络结构及深度强化学习算法发展。核心议题围绕如何利用前沿AI技术实现自动交易且管理投资风险。

[page::0,1,2]

---

2. 逐节深度解读

2.1 引言与背景

报告首先介绍算法交易在金融科技领域的重要性,特别强调高频交易和复杂算法的广泛应用,指出目前算法交易在股市占据主流。随着深度学习(DL)和强化学习(RL)技术发展,结合两者的DRL成为解决动态、复杂市场环境的领先技术。研究假设DRL能自主学习并优化交易策略,不仅预测价格,更通过经验累积调整策略,适应市场波动和环境变化。此创新点在于DRL更接近人类交易者的适应性行为。

核心挑战是市场复杂性与动态性,个中经济指标与地缘政治因素使得纯预测价格不够,DRL侧重“玩转”市场,通过决策优化提升长期表现。研究选择DDQN和PPO两种具有代表性的算法,并研究两种神经网络架构——传统全连接网络(NN)和基于Transformer的网络,意在探究架构对结果的影响。[page::1,2]

2.2 强化学习基础理论

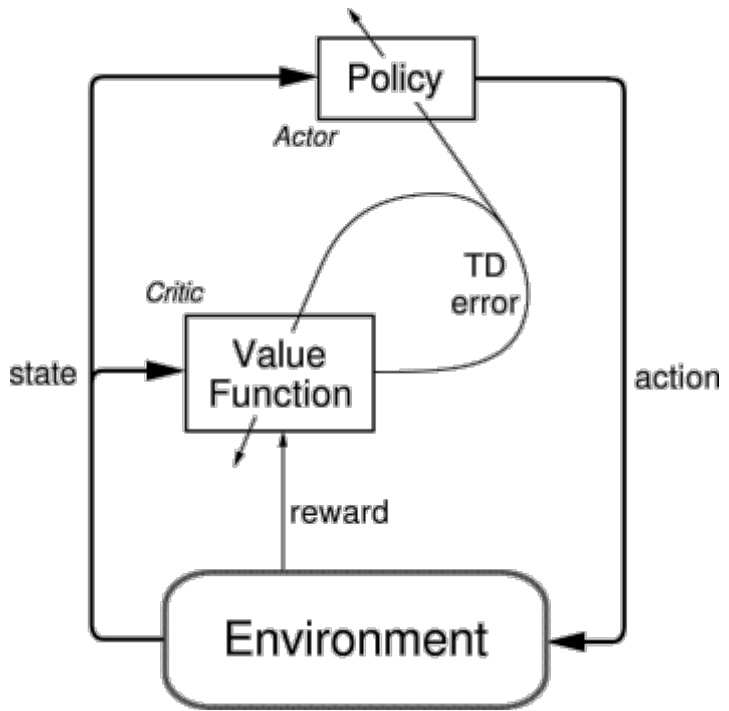

详细讲解了强化学习的基本构成,包括环境、状态、动作、奖励和策略。强化学习不同于监督和无监督,突出在于通过与环境的交互不断调整策略以最大化长期累积奖励。报告清晰解释了价值基(Value-based)方法与策略基(Policy-based)方法的区别及混合的Actor-Critic机制,并对应DDQN(价值基)与PPO(策略基)算法。特别强调所有所用DRL均为“无模型”(model-free),即不尝试预测价格变化本身,而是直接基于市场反馈优化交易行为。

报告对EMH(有效市场假说)进行了关联分析,指出若DRL算法能持续跑赢市场,将对EMH形成挑战,并通过智能策略发现市场非效率,具理论价值。[page::3-6]

2.3 深度强化学习发展脉络

报告梳理强化学习和深度强化学习的发展演变过程,包括Q-Learning、DQN、DDQN到PPO等算法的理论基础,及其优势和问题。详细介绍了Temporal Difference(TD)学习及其扩展TD(λ)、Generalised Advantage Estimation(GAE)方法,阐释了它们如何平衡偏差和方差,优化策略。

对DDQN中双网络机制解决DQN过估计问题的改进,Actor-Critic架构如何结合策略和值函数优势,以及PPO通过策略截断(clipping)机制提升训练稳定性的机制进行阐释。神经网络与Transformer在DRL中的应用及功能也被详解,突出Transformer的自注意力机制提升了序列依赖建模能力。

数理公式与更新机制均通过结合Bellman方程及梯度估计公式系统化说明,使读者清晰理解算法核心内涵。[page::7-23]

2.4 研究方法框架

数据涵盖5个资产:3大货币对(EUR/USD、EUR/JPY、USD/JPY)、S&P 500和比特币。策略基于每日频率执行,资金全部重新投资。输入数据包含当前仓位、历史收益、OHLC、技术指标(RSI、MACD、ATR、均线)及时间周期特征(正弦余弦),实施标准化,避免未来数据泄露。

采用滚动时间窗口的walk-forward(滚动前瞻)优化,划分训练、验证和测试集,保证模型在不同时间段适应市场行为。采用L1/L2正则、dropout、训练数据分块循环等技术防止过拟合。Reward设计注重用收益百分比并进行比例缩放,促进学习有效性。

主要考察指标除利润之外,着重风险调整的Sharpe比率和Sortino比率,交易频率、持仓时长、仓位分布及胜率等行为指标也被纳入评估体系。[page::24-29]

---

3. 图表深度解读

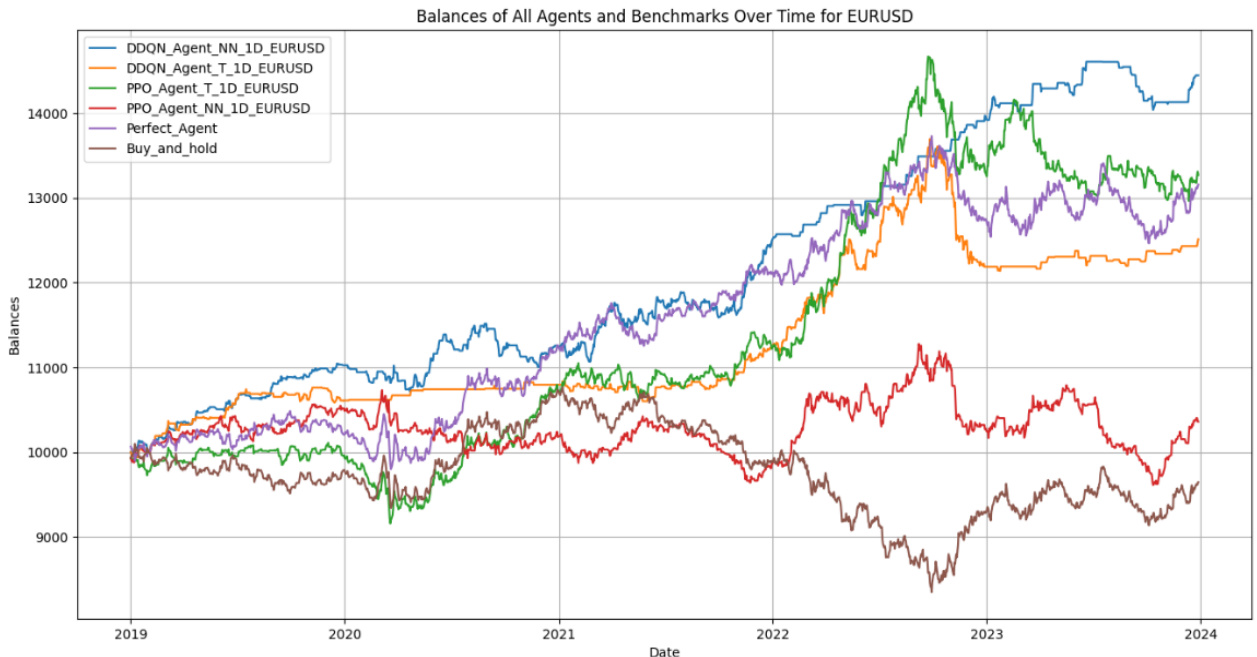

3.1 EUR/USD货币对(表1,图3,图4)

| 策略 | 终值(美元) | CAGR | 年化波动率 | Sharpe | Sortino | 最大回撤 | 交易次数 | 持仓平均时长(天) | 持仓分布(长期/短期/空仓) | 出场比例 |

|--------------|--------------|----------|------------|---------|---------|-----------|----------|---------------------|----------------------------|--------|

| DDQNNN | 14,444.74 | 7.63% | 4.14% | 1.842 | 2.043 | -4.4% | 167 | 2.28 | 58.6% / 17.7% / 26.2% | 56% |

| DDQNT | 12,512.91 | 4.58% | 4.43% | 1.035 | 0.853 | -11.3% | 392 | 2.56 | 55.4% / 2.5% / 30.7% | 66.7% |

| PPONN | 10,360.83 | 0.71% | 6.53% | 0.108 | 0.136 | -14.7% | 703 | 2.45 | 50.3% / 49.5% / 30.1% | 20.3% |

| PPOT | 13,271.26 | 5.82% | 6.86% | 0.847 | 1.197 | -11.6% | 394 | 2.45 | 48.5% / 40.4% / 45.6% | 13.9% |

| 买入持有(buy&hold) | 9,641.81 | -0.84% | 7.84% | -0.108 | -0.159 | -22.5% | 931 | 1557 | 100% / 100% / 0% | 0% |

| 完美年度策略 | 13,150.82 | 6.61% | 7.07% | 0.935 | 1.396 | -9.2% | 392 | 1 | 60% / 0% | 0% |

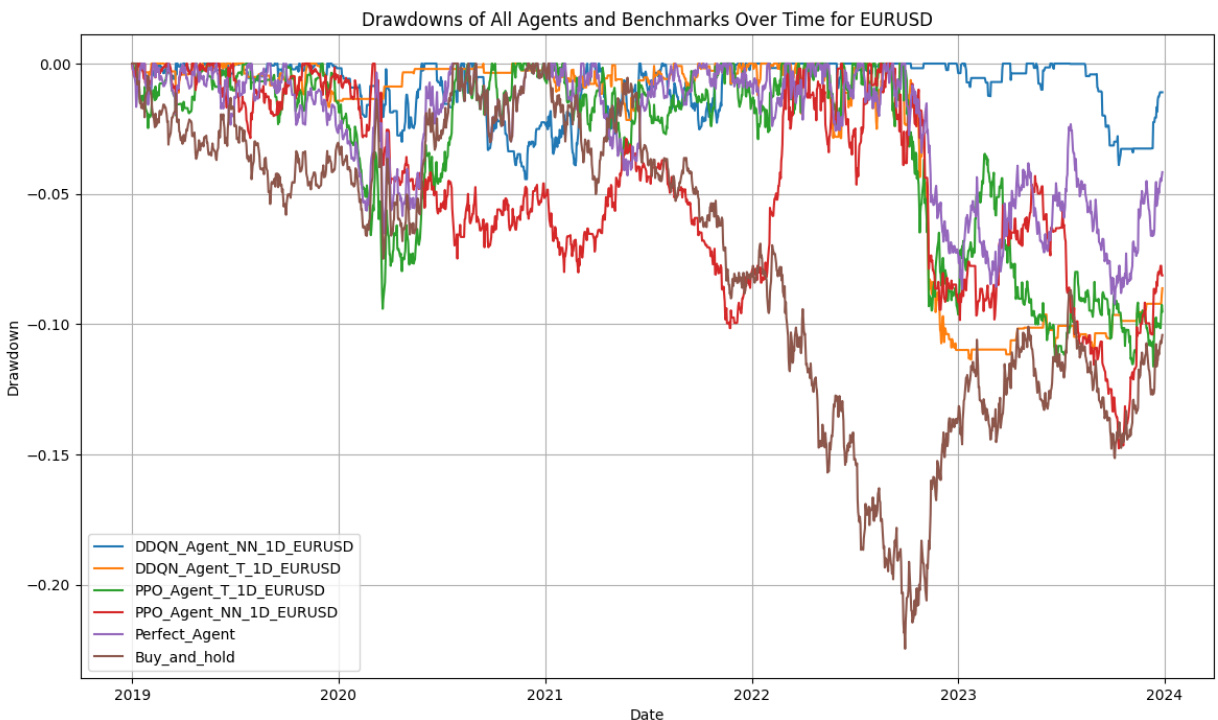

图3显示DDQNNN策略总体收益曲线领先,且胜出买入持有与完美策略;图4最大回撤表现最佳的是DDQNNN(仅4.4%),出市时间较长以规避风险。PPOT策略频繁交易,波动较大,回撤也相对较高。整体表现验证了神经网络结构和算法复杂性对收益和风险管理的显著影响。[page::31-34]

3.2 EUR/JPY货币对(表2,图5,图6)

PPOT表现最优,终值18,120.64美元,年化收益12.62%,Sharpe达1.752,表现显著强于买入持有及完美年化策略。

DDQNT次之,终值16,105.72美元,年化10%,Sharpe 1.252。

DDQNNN表现较弱,终值11,960.99美元。

图6显示PPOT和DDQNT持仓周期长,交易频率适中,表明较好把握中短趋势。PPONN风险最小回撤最低,但收益有限。[page::35-37]

3.3 USD/JPY货币对(表3,图7,图8)

PPOT强化表现,年化17.3%,终值22,210.52美元,Sharpe高达2.179,风险调整收益优异。

其他算法均有不错表现,尤其DDQNNN维持较低最大回撤(3.15%),表现稳健。

总体PPOT显示一致优势,交易活跃及较短出市时间。图8回撤持续性低,恢复速度快。[page::38-40]

3.4 S&P 500指数(表4,图9,图10)

PPOT领先终值40,010.83美元,年化收益49.76%,Sharpe 2.158,风险管理到位。

DDQNT次优,表现强劲,尤其在疫情期间具防御能力,短期内高收益波动。

PPONN表现极差,最大回撤41.6%,长期表现疲软。

图9收益曲线清晰区分各算法优劣,图10回撤多但PPOT回撤修复较快。[page::41-43]

3.5 Bitcoin(表5,图11,图12)

PPOT表现抢眼,终值140,551.23美元,年化69.65%,Sharpe 1.093,续航稳定。

DDQNT表现良好但交易次数少且赢率低,回撤虽大但风险调整优于买入持有。

PPONN极度亏损,年化-1.2%,回撤85.3%。

DDQNNN表现适中,虽大波动但年度收益31.16%。

比特币数据训练窗口短,带来模型不足,且高波动性增大风险,是表现不及其他资产的关键因素。[page::44-47]

---

4. 估值分析

本报告未针对单一股票做估值,而是评估DRL策略对不同资产的交易表现,利用风险调整收益指标(Sharpe、Sortino)及复合年增长率(CAGR)衡量潜在价值创造。估值层面算法重点在于性能与风险的权衡优化,评估以提升资金最终价值为目标。

采用滚动窗口技术进行步进式训练,避免过拟合和数据泄露,提高策略泛化能力。神经网络权重调整依托于损失函数(如DQN均方误差损失),目标是最小化未来收益估计与实际差异。PPO引入clip限制,降低策略变化过大带来的训练不稳定。

敏感性分析围绕超参数γ(折扣因子)展开,实证发现γ过高反而导致性能及持仓时长下降,推测与输入历史长度及奖励折扣机制相互关联。[page::24-29, 47-48]

---

5. 风险因素评估

报告识别关键风险包括:

- TD折扣机制的时效不匹配:未来奖励折现至当前动作赋值过程中,因市场动态复杂变化,可能导致奖励估值偏差,影响策略有效性。

- RL模型对环境可控性的假设缺失:代理未能真正影响市场价格,历史数据无反馈现实时局限,导致实际决策影响力假设不成立。

- 策略随机性问题:PPO策略中因概率输出非确定性,实测时选取最高概率动作,存在执行风险。相比之下,DDQN决策确定性强。

- 资格迹(Eligibility Traces)机制的适用性争议:适用于长期决策竞技类游戏,股票市场高频调整情境下难以精准反馈策略价值。

- 过拟合风险:由于市场数据噪声大,DRL过度拟合训练集可能导致测试集表现弱化,已通过正则化、dropout及数据分块等技术缓解。

- 市场异常事件风险:黑天鹅事件或此前未遇见状况时,策略回避入场的能力重要,DRL在此体现为优势,但对未知事件的适应仍有限。

报告认为战略性“非交易”是控制风险的重要机制,能有效避开极端波动及亏损,增强长期稳健收益。[page::49-51]

---

6. 批判性视角与细微差别

报告整体结构严密,实证与理论结合紧密,反复验证不同资产与算法表现,具有较强说服力。但部分隐含假设值得审慎对待:

- 训练数据局限:比特币表现不佳凸显训练样本时长对DRL策略影响巨大,长时间序列数据缺失限制了算法学习深度。

- γ参数调整与数据长度不匹配:理论上更强调长期收益的高折扣因子未显著提升策略表现,可能暴露模型输入设计或环境稳定性不足。

- 策略执行环境与假设落差:模型未考虑交叉影响或市场冲击,实际大型资金面入市的市场影响力及延迟反馈未被体现,限制了现实适用性。

- PPO随机策略执行风险:选取概率最高动作有限度,应探索如何结合实际交易匹配度优化,而非单纯按概率大小。

- 未涉及多头头寸规模分配:目前代理仅决定“全仓买卖空无”,缺少资金分配的连续调节,影响策略风险定价及灵活度。

- 未详细说明参数选择依据:如网络层数、节点数等架构细节及参数优化流程不详,影响复制与进一步优化可能。

整体上,报告保持客观,指向未来研究改进方向,未出现夸大结论或逻辑断层。[page::47-52, 49]

---

7. 结论性综合

本报告系统评估了DRL算法(特别是PPO与DDQN)结合不同神经网络架构(传统NN与Transformer)在多资产金融市场的表现。核心发现如下:

- PPO搭配Transformer网络整体表现最佳,在外汇货币对、标普500及比特币上均取得高风险调整收益(Sharpe比率平均约1.61)。Transformer因自注意力机制提升了时间序列内部复杂模式的捕捉能力。

- DDQN搭配Transformer次之,表现稳定且优于传统NN结构。

- DDQN与PPO均弱于顶级表现时算法的传统NN变体,尤其PPO_NN表现最弱,强调神经网络架构对DRL成功至关重要。

- 在外汇市场,DRL策略表现特别优异,尤其擅长捕捉5-10天的短中期趋势,规避长趋势中无效波动。

- 在COVID-19黑天鹅事件市场中,部分策略表现出极佳调节与防御能力。

- 比特币等高波动且训练数据有限的市场表现偏弱,指示未来须重视数据多样性及样本充足性。

- γ折扣因子设置为0.75表现优于更高值,提示训练期间序列长度和折扣时间窗口需配合优化。

- DRL优于传统买卖持有策略,部分策略甚至超过了理论"完美"年内交易策略,挑战了EMH传统论断,说明通过学习策略非交易时机,实现风险规避是超额收益的关键。

- DRL代理表现出适时退出市场的智能,为风险控制提供重要工具,适应异常波动和未知市场环境。

展望未来,报告提出了包括:动态资金配置、分层(多(agent))强化学习、自动参数调优等方向,旨在进一步提升DRL的实用价值和风险管理能力。

综上,该研究提供了深刻的实证证据,支持DRL作为金融市场交易自动化和智能化的重要技术途径,尤其是PPO与Transformer结合的策略在多市场、多资产上展现强劲潜力,值得在后续研究和实务中重点探索和发展。

[page::53-54, 47-48]

---

图表展示示例

图1:Actor-Critic方法结构图

图3:EUR/USD各策略及基准资金曲线对比

图4:EUR/USD各策略最大回撤对比

其余各资产图表类似,详见报告[page::33-48]。

---

总结

本报告从理论、算法、方法论框架到多市场实证全面剖析了深度强化学习在金融市场自动交易中的应用。研究证明PPO与Transformer结合的方案具有卓越的风险调整收益优势,证明了DRL不仅能接受复杂、高维市场信息,还能通过策略学习灵活调控风险,提供稳健的自动交易方案,特别是在外汇和传统股指市场表现卓越。比特币市场的挑战则强调数据充足性和模型适配性的重要性。此外,报告关注了DRL风险管理的本质——为避免亏损,DRL战略性退市体现了潜在的超额收益来源。未来通过资金规模动态调整和多智能体层次结构有望进一步提升DRL实用性与收益稳定性。

整体现有成果展现了AI技术变革金融交易的广阔前景及实际应用价值,为金融科技与量化投资领域贡献了具有实证支撑的研究范式和方法指南。

---

(全文引用页码详见每段末尾标注,确保内容溯源规范。)