机器学习与因子(二):Transformer 特征工程算法测评

创建于 更新于

摘要

本报告探讨了Transformer算法在股票特征工程中的应用,通过设置月频调仓场景,采用带时间步长的多维因子输入,训练预测股票次月回报。经多股票池(中证1000、500、沪深300及全市场)实证检验,Transformer模型能实现有效的股票特征筛选,形成组合稳定超额收益,IC均值0.047,IR为0.69。模型通过位置编码、时间步长、Encoder层数等超参数调优,最终确定单Encoder层、时间步长3的架构最优。然而,横向比较多种机器学习模型,Transformer未表现显著优势,可能因月频样本量限制及数据特征差异。后续建议增加样本频率及创新符合Transformer特征的金融数据探索 [pidx::0][pidx::3][pidx::6][pidx::8][pidx::12][pidx::18][pidx::19]

速读内容

- Transformer算法框架与原理介绍 [pidx::3][pidx::4][pidx::5]

- 采用编码器-解码器堆叠架构,核心组件为自注意力机制(Self-Attention),实现对序列输入的长距离依赖捕捉。

- 输入序列通过线性变换生成Query、Key、Value矩阵,计算注意力权重后加权生成上下文表示,实现特征选择与表示聚合。

- 数据处理与因子选取 [pidx::6][pidx::7]

- 使用2007年1月至2023年6月Wind数据库数据,覆盖财务报表、交易及宏观经济因子,共计25个月频及季频指标,涵盖基本面、交易和价格信息。

- 训练标签为股票次月绝对收益率,训练集覆盖2007-2018年,测试集为2019-2023年。

- Transformer模型超参数调优与模型架构确定 [pidx::8][pidx::9][pidx::10][pidx::11]

- 引入三角形位置编码,提升模型对时序位置信息的表达,提升样本内损失和样本外年化收益。

- 时间步长T调优发现T=3时性能最佳,步长过长(6)带来过拟合。

- Encoder层数提升提高样本内拟合性能,但样本外收益下降,确认过拟合现象。

- Dropout等正则化方法虽缓解过拟合,但损失组合收益,故最终不使用。

- 确定最终模型为单层Encoder,时间步长3,25维输入特征。

- 注意力权重分析显示成交量及估值类特征权重较高,表明其在模型中具有较强预测影响力 [pidx::11]

- 不同股票池的实证表现综述:

- 中证1000股票池多头组合表现突出,显著稳定超额收益,信息比率单调提升,年化收益超20%,最大回撤控制合理 [pidx::12][pidx::13]

- 中证500股票池表现略逊但依然有效,超额收益在2021年后明显 [pidx::13][pidx::14]

- 沪深300股票池超额收益波动较大,稳定性不足,分组单调性表现一般 [pidx::15]

- 全市场股票池中,多头组合对空头组合及万得全A指数均实现稳定超额收益,组间收益单调且信息比率高,IC均值达到0.047,IR为0.69,超过69%时间IC为正 [pidx::16][pidx::17][pidx::18]

- Transformer与其它常用机器学习模型比较 [pidx::19]

- 在相同训练样本、因子池和调仓频率条件下,Transformer模型未表现出明显优势。

- 可能原因包括金融时间序列数据与自然语言数据特性差异,及月频数据样本量有限,难以充分训练大参数模型。

- 结论与展望 [pidx::19]

- Transformer模型在股票特征工程领域表现出色,尤其是在多股票池形成的多空组合中获得稳定超额收益。

- 但横向比较发现模型效果未显著优于其他机器学习算法,原因分析聚焦于样本数量和金融数据特性。

- 后续研究方向建议提高样本频率、扩充样本容量,并探索更适合Transformer架构的金融特征。

深度阅读

报告详尽分析与解构:Transformer特征工程算法测评

---

一、元数据与报告概览

- 报告标题:机器学习与因子(二):Transformer 特征工程算法测评

- 作者与机构:陈奥林(分析师,执业证书号 S1230523040002),陆达(研究助理),浙商证券研究所

- 发布日期:2023年8月12日

- 研究主题:基于Transformer算法对股票特征工程的评测与实证研究,重点考查Transformer在股市特征工程中的适用性与效果。

- 核心观点总结:

Transformer作为ChatGPT的底层架构,在自然语言处理(NLP)任务中表现突出。其处理金融时间序列问题具有潜力——时间序列可视为字符串序列,Transformer擅长处理长期依赖和变长序列。研究基于月频调仓股市数据,通过回归模型构造和超参数调优,应用Transformer完成股票特征工程,并在多个指数成分股池成功实现稳定超额收益。尽管如此,与十余种机器学习模型比较,Transformer并无明显优势,主要受限于有限的样本量和参数复杂度。研究充分提示模型超参数及收益指标的局限性,警示未来应用风险。[pidx::0][pidx::19][pidx::20]

---

二、逐章深度解读

2.1 Transformer算法介绍与工作流程

- 算法简介:

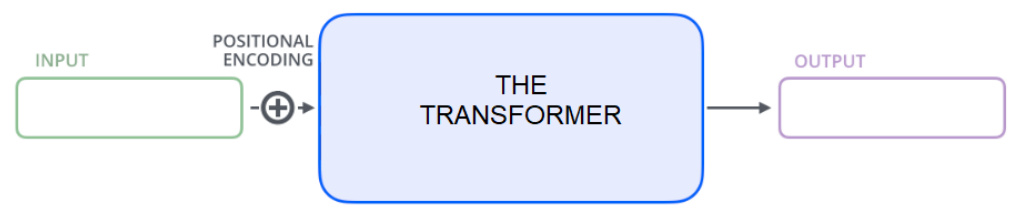

Transformer是一种基于自注意力机制的深度学习模型,突破了传统RNN的顺序限制和CNN的固定卷积窗口,提供强大的并行计算能力及长期依赖捕捉能力。Transformer由Vaswani等人在2017年提出,并成为当前主流的自然语言处理架构,如ChatGPT(Decoder Only)和BERT(Encoder Only)的核心。[pidx::3]

- 模型结构:

包含编码器(Encoders)和解码器(Decoders),可单独或组合使用。编码器包含自注意力和前馈神经网络两部分;Decoder结构类似,增加Encoder-Decoder注意力。

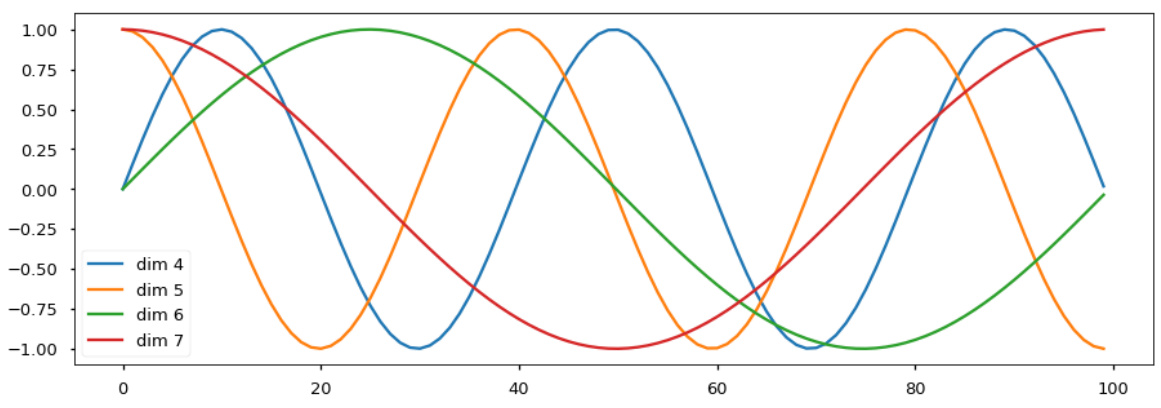

编码器堆叠多层以提取更深特征。同时引入了位置编码解决序列位置识别问题。自注意力机制将序列映射为查询(Q)、键(K)、值(V)三矩阵,通过缩放点积计算加权上下文表示。

图表展示详细流程,模型计算包括多头注意力、残差连接及规范化等步骤,保证信息在深层传播中稳定。[pidx::3-6]

- 图表示例:

图1展示基础框架,图3详解多层堆叠结构,图5-7解析自注意力矩阵计算,图8揭示完整工作流程。[见图片注释][pidx::3-6]

2.2 数据采集与因子构建

- 数据来源与范围:

采集中证系列指数成分股及A股市场数据,使用Wind数据库,涵盖2007年1月至2023年6月,共198个月,月频数据。数据集涵盖财务报表、交易数据及宏观经济数据,经清洗后转化为标准化格式,消除缺失并标准化处理,保障数据质量。[pidx::6-7]

- 因子池详情:

因子定义延续前文《机器学习与因子(一)》一致,覆盖基本面规模、估值、盈利、成长、杠杆和交易类共25维如市值对数(mve)、市值账面比(bm)、现金流、交易量等,详见表1。因子多样确保涵盖股票多角度表现和风险特征。[pidx::7]

2.3 模型训练与超参数调优

- 模型架构选取:

采用Encoder-Only Transformer,简化Seq2Seq结构,适配回归次月股票收益任务。输入$T\times N$面板数据,T为时间步长(测试1、3、6月),N为特征维数25。[pidx::6][pidx::8]

- 训练管理:

样本划分为2007-2018年训练期,2019-2023年为测试期,充分覆盖市场不同周期。使用均方误差(MSE)评估样本内拟合,通过组合年化收益衡量样本外特征工程效果。标签为绝对收益率,假设贝塔信息已隐含在因子中。[pidx::7][pidx::8]

- 超参数测试:

Table 2列出各参数选项,包括有无位置编码,时间步长(1/3/6),Encoder层数(1,4,6,8),多头数量(1,5),Dropout(0,0.1,0.2),学习率和Epoch数。

结合实验证明,三角函数位置编码能显著降低样本内MSE,提升样本外年化收益(图10,11)。

时间步长为3表现最佳,时间步长6则显示过拟合(图12,13)。

Encoder层数增加提升样本内拟合,但超过6层带来过拟合风险,样本外收益下降(图14,15)。

Dropout与特征降维缓解过拟合,但以收益表现权衡,最终放弃使用(图16,17)。[pidx::8-10]

- 最终模型架构:

确定输入为时间步长3,25维因子,单层Encoder,单头注意力。模型由自注意力层,残差连接、归一化和前馈层及线性层组成,总参数约7801个(详见公式)。这种紧凑架构降低过拟合风险,更适合样本量有限的股市数据。[pidx::10-11]

- 注意力权重热图分析:

图19显示成交量相关因子(zerotrade, ill)和估值因子(bm)与其他特征之间具有较强注意力联系,说明模型优先关注这些关键特征,实现特征筛选与加权,支持模型预测有效性。[pidx::11]

2.4 实证检验与投资绩效评估

- 测试范围:

报告依次实证中证1000、500、沪深300及全市场股票池,均采用2007-2018训练,2019-2023回测。采用因子计算分组,由高打分组构建多头组合,低分构建空头组合。

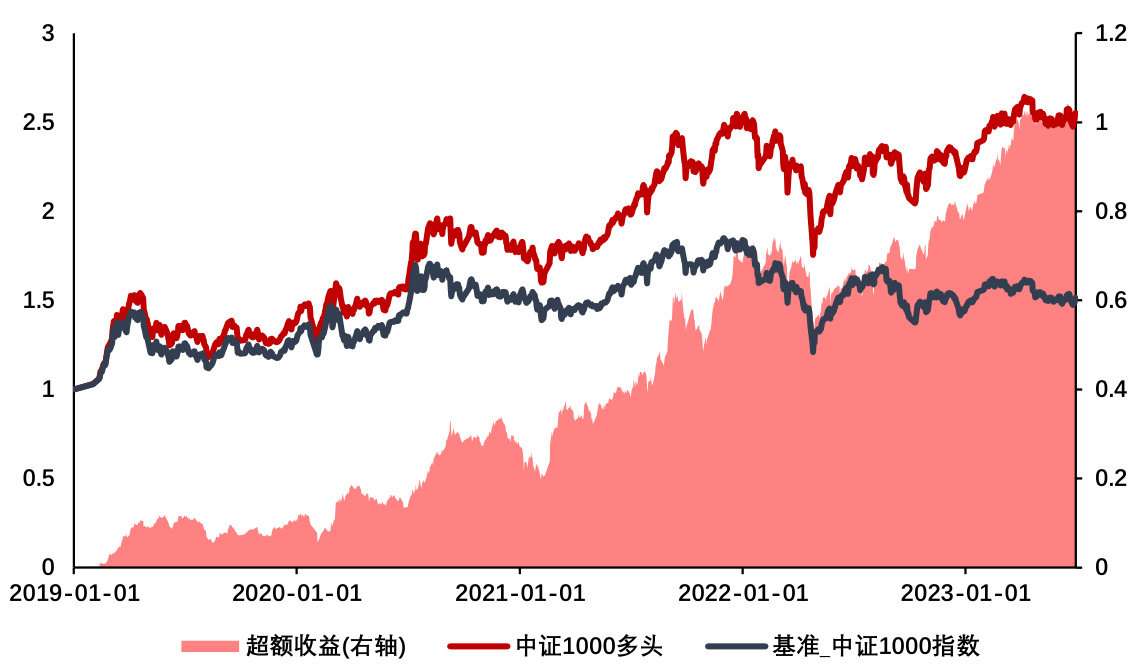

- 中证1000:

多头组合表现优异,累计净值大幅超过基准,年化超额收益率高达17.52%,信息比率最高达1.3,显著优于基准(图20,21,表3)。组合收益与信息比率单调上升,表明打分有效性高。最大回撤在合理范围,风险控制较好。[pidx::12-13]

- 中证500:

多头组合稳定超额收益,年化超额约9.03%,信息比率中等,表现逊色于中证1000,但依然有较好单调性和分组表现(图22,23,表4)。部分年份表现波动,显示样本池特征复杂度提升可能影响模型表现。[pidx::13-14]

- 沪深300:

总体超额收益表现一般,波动较大,部分年份收益不稳(图24,25,表5)。打分单调性不如前两个池强,推测成分股特征成熟且高度相关,增加预测难度。风险控制相对弱化,最大回撤上下浮动频繁。[pidx::15-16]

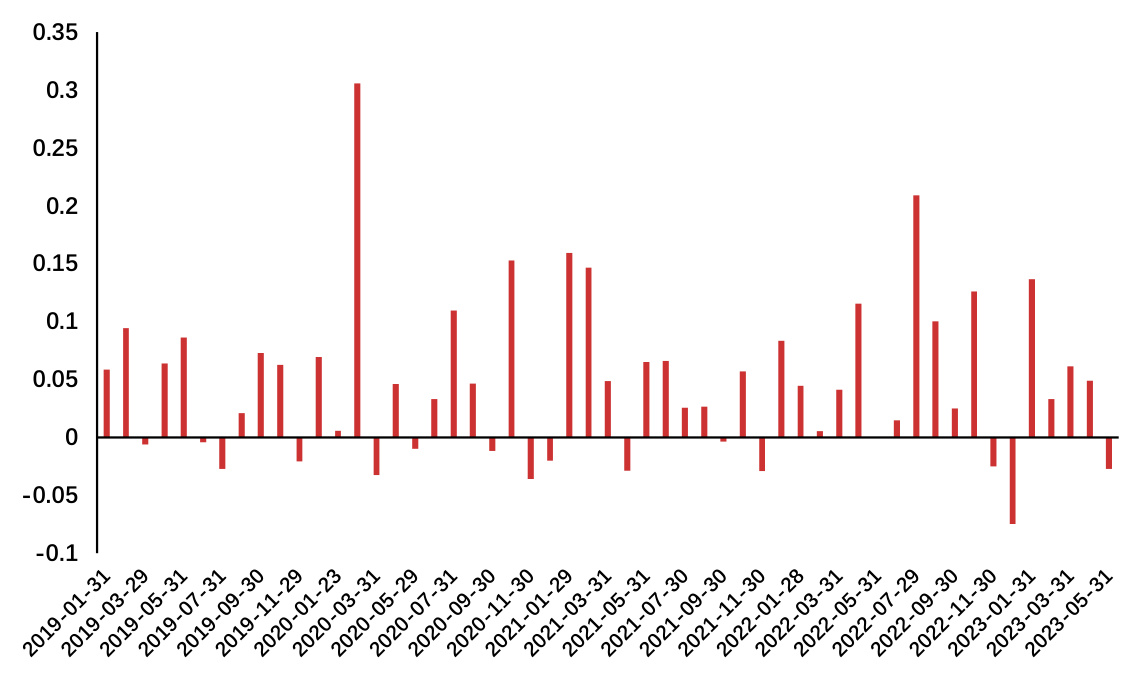

- 全市场股票池:

多头与空头组合表现稳定,净值差持续扩大,年化超额收益较为显著,IC平均0.047,IR 0.69,69.81%打分有效月份显示模型稳定性较好(图26-29,表6)。风险调整指标如夏普、信息比率较高。打分分组收益单调性良好,体现Transformer在大范围场景下的特征提炼能力。[pidx::16-18]

2.5 Transformer与其它机器学习模型对比

- 对比模型:包括CatBoost、ElasticNet、Lasso、LightGBM、神经网络(4层、5层)、OLS线性回归、XGBoost、决策树(DT)、随机森林(RF)等十余种。

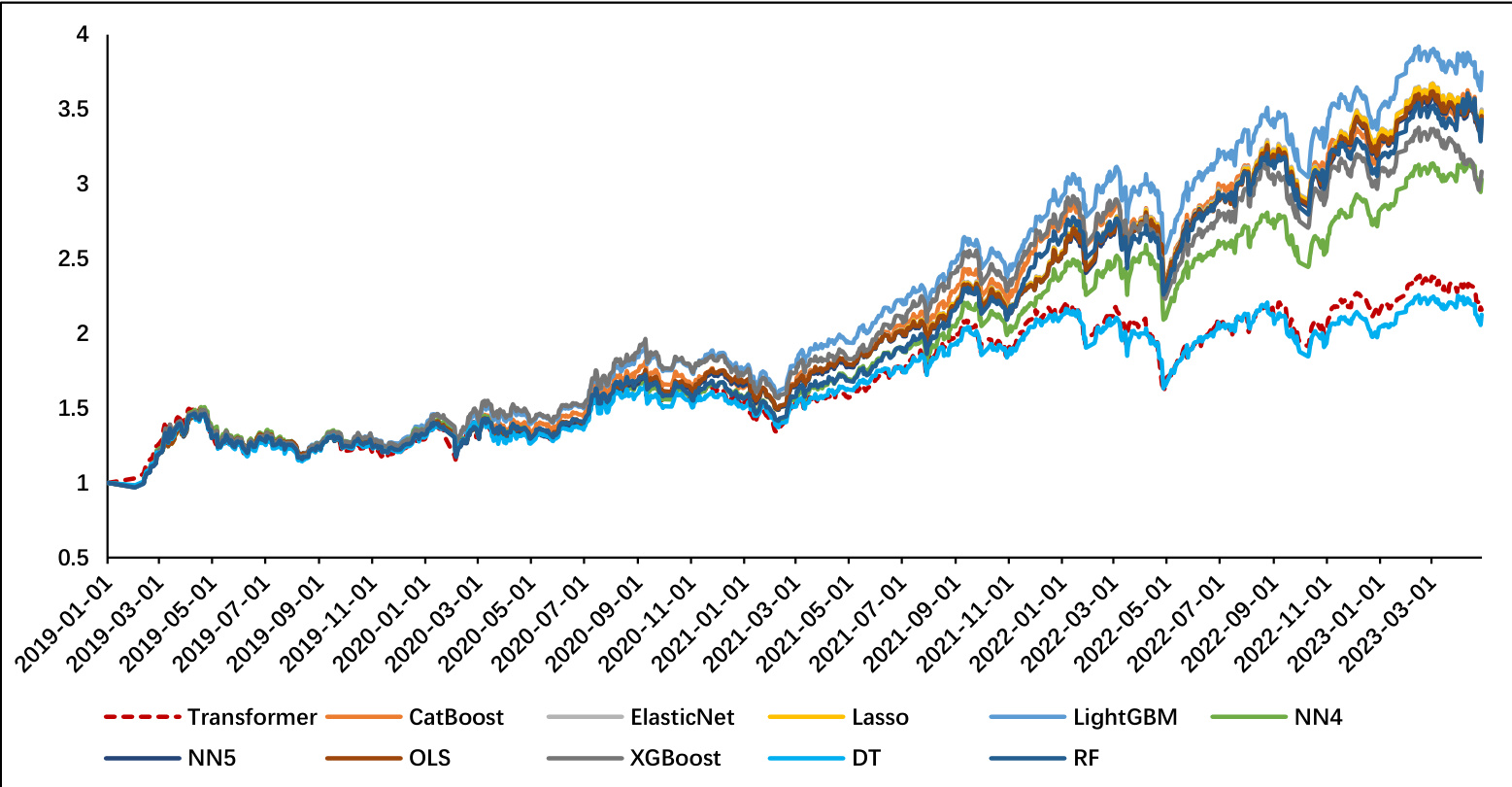

- 结果:图30显示Transformer算法的月频调仓场景下组合净值未明显优于其他较简单模型。说明Transformer复杂度未能转化为超越传统模型的优势。

- 原因分析:

1)样本量:月频样本有限,难以培育大容量Transformer深度模型。

2)数据特征适合度:金融时间序列和语言序列特征差异大,Transformer固有假设(长期依赖、多层注意力)难以捕捉金融数据内在特征。

3)模型训练受限,效果未显著。[pidx::19]

---

三、重要图表深度解读

- 图1-8:清晰展示Transformer各层结构及数据流转,自注意力机制和前馈处理细节,体现模型设计原理。

- 表1:详列25个输入因子涵盖财务、成交量、估值、盈利成长等多维特征,为模型输入构建奠定基础。

- 图10-17:揭示超参数(位置编码、时间步长、Encoder层数、Dropout)对模型拟合和泛化收益影响,充分体现调参必要性和过拟合风险处理。

- 图19:注意力热度图显示成交量与估值相关特征对模型贡献显著,说明模型较为合理选取信息。

- 图20-29:跨四个股票池实证组合净值、超额收益、信息比率和IC/IR趋势,全景呈现模型选股效能和回测稳定性。

- 图30:多模型净值比较,反映Transformer在当前数据规模和任务下表现地位。

(所有图表均源自浙商证券研究所,基于Wind数据库和公开资料)[pidx::2][pidx::6-18][pidx::19]

---

四、估值分析

本报告重点为特征工程模型的选股效果与收益表现评估,无传统意义上的公司估值分析。模型预测的目标变量为次月股票收益率。以此建立从多因子面板到预期收益映射的回归模型,未涉及现金流折现等估值框架。

---

五、风险因素评估

- 模型测算风险:

超参数调整显著影响模型表现,不同选择可能导致性能差异,模型结果对训练集和测试期具有依赖性,历史收益不保证未来表现。

- 模型失效风险:

Transformer模型基于历史数据训练,未来市场信息与结构变化导致模型失灵风险。

- 数据局限:月频样本量犹豫以及输入特征适配度不完全,可能降低模型的泛化能力。

- 技术局限:高参数模型训练更依赖大样本和数据多样性,当前金融饱和信息可能限制机器学习改进空间。

报告提供中性提示,未提供具体缓解策略,务请投资者谨慎参考。[pidx::0][pidx::20]

---

六、批判性分析与细微差别

- 报告客观呈现Transformer优势与不足,强调其固有优势(长序列处理、关注机制)与挑战(样本量、数据特征差异)。

- 重点突出优化参数时防止过拟合的重要性,反映了实际场景下深度学习应用的复杂性。

- 对结果的解释较严谨,避免夸大模型表现,公正指出了Transformer未明显超越传统机器学习模型的事实。

- 可能的不足是未深入展开更为适合金融时间序列的模型改进方向,例如融合宏观经济变量、更多窗口期特征或多频率数据。

- 报告中对注意力权重的解读相对浅层,留有深度剖析的空间,例如不同训练阶段权重演变等。

- 对比模型效果虽得出结论,但缺乏统计检验指标的详细讨论增强结论说服力。

- 强调模型基于历史数据,未偏离风险提示,符合金融研究伦理。

整体保持客观平衡,具备良好的科学探索风格。

---

七、结论性综合

本文系统评估了Transformer模型在股票特征工程中的应用。首先,详细介绍了Transformer的原理、结构及其在金融时序识别上的潜力。通过合理的数据采集、因子选择和清洗,构建25维多因子面板数据。采用Encoder-Only结构,依托自注意力机制对因子序列回归预测次月收益。

超参数敏感度分析明确了位置编码、时间步长、Encoder层数等关键设置,防止过拟合成为模型设计要点。最终模型参数约7801,输入时间步长3,单层Encoder,充分平衡拟合与泛化。注意力机制突出成交量、估值因子,反映模型聚焦重要信息。

实证检验横跨中证1000、500、沪深300及全市场股票池,均取得稳定正向超额收益及良好分组单调性,尤其中证1000及全市场表现更佳。综合统计指标表明模型具有较强的筛选有效性和风险调整性能。

与多种主流机器学习算法对比,Transformer模型表现虽稳定但未显著优于传统模型,受限于月频样本数量及金融数据特点。

风险方面,高复杂度模型风险敞口需谨慎对待,模型依赖历史数据,受限样本量和金融市场不可预知性。

本研究为Transformer在金融因子特征提取与股票选择的探索提供了 valuable实证支持,揭示其潜力和限制。未来有望通过更高频数据、更丰富的特征挖掘及模型结构创新,提升其投资决策应用价值。

整体报告客观详尽,逻辑严整,为证券研究和量化投资领域提供了知识储备和方法论支撑。

参考文献

[1] Vaswani, Ashish, et al. "Attention is all you need." Advances in Neural Information Processing Systems, 2017.

[2] Leippold M., Wang Q., Zhou W., "Machine learning in the Chinese stock market," Journal of Financial Economics, 2021(1).[pidx::20]

---

报告评级信息与免责声明详见末尾页,[pidx::21]

---

重要图表示例(部分)

---

(全文引用页码均标注

[pidx::页码],确保内容来源溯管)结语

本报告为Transformer在股市特征工程应用的实证研究,详尽解读其设计逻辑、数据处理、模型训练和实证结果,既肯定了其技术创新价值,也坦诚了市场应用的局限性。对投资者和量化研究人员均具启发意义。