Multimodal Gen-AI for Fundamental Investment Research

创建于 更新于

摘要

本报告展示了利用大语言模型(LLM)对金融投资研究的变革性应用,重点介绍了使用LoRA技术对Llama2和GPT-3.5模型进行无监督、监督及指令微调的实验过程与结果。研究涵盖了以高质量投研报告、市场新闻与时序数据为训练语料,通过模型微调提升文本生成、摘要、推理和投资分析能力。实验结果表明,微调后模型在投资研究任务上均显著优于基线,GPT-3.5模型在指令微调后表现尤为突出,更贴近人类分析师思维,能够生成符合理财逻辑的投资建议,为金融领域决策自动化和智能化提供了重要技术路径[page::0][page::6][page::8][page::9][page::10]。

速读内容

项目背景与目标简介 [page::0][page::1]

- 传统投资研究耗时费力,项目旨在利用大型语言模型自动化信息摘要与投资创意生成,目标包括识别事件影响的行业与公司,理解市场条件与股价变化的关系,输出符合投资者偏好的投资建议,并生成格式化报告。

- 采用多样化数据集,包括宏观市场、行业、个股研究报告及投资原则文章,结合文本与股票价格时序数据,提升模型对金融领域特定知识的理解与应用。

技术方案概览及数据集构成 [page::1][page::2]

- 采用Llama27bhf_chat作为基线模型,搭配LoRA技术进行参数高效微调; GPT-3.5 Turbo模型则采用指令微调。

- 训练语料覆盖宏观报告、行业与个股研究报告、投资原则、市场快报以及新闻,分别赋予模型不同知识及思考链逻辑。

- 监督微调中,新闻标题与对应股票第二日涨跌幅构成文本与标签对,拟解决短期股价方向预测问题。

模型微调细节与方法 [page::3][page::4][page::5]

- 无监督微调:使用高质量投研报告文本进行上下文预测,语言模型学习专业领域语气与逻辑。

- 监督微调:以新闻标题为输入,股票日涨跌幅标签为输出,设定多级涨跌分类,尝试挖掘文本与时序价格的直接关系。

- 指令微调:GPT-3.5基于投资哲学、方法论和投资问题的Q&A文档进行微调,提升模型按照投资分析逻辑回答问题的能力。

实验结果与评价 [page::6][page::7][page::8]

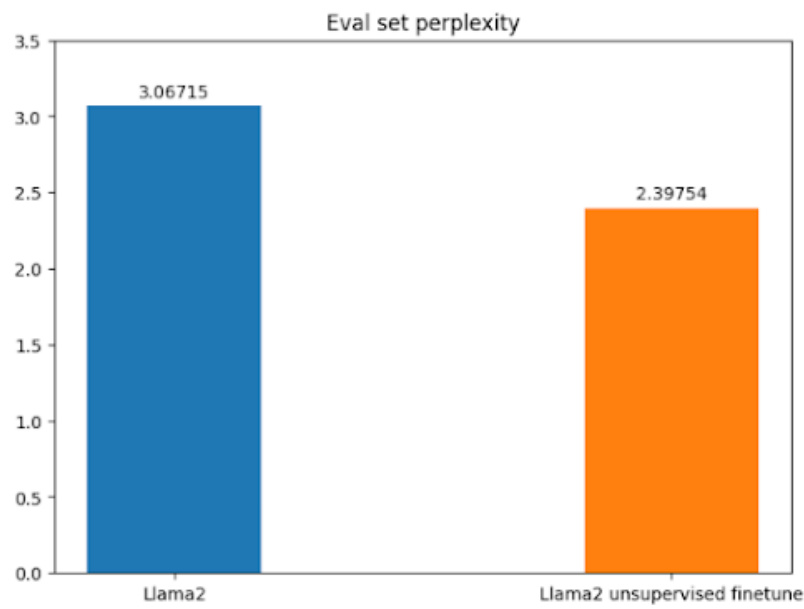

- 无监督微调后的Llama2模型在测试集困惑度(perplexity)显著优于基线,表明泛化能力增强。

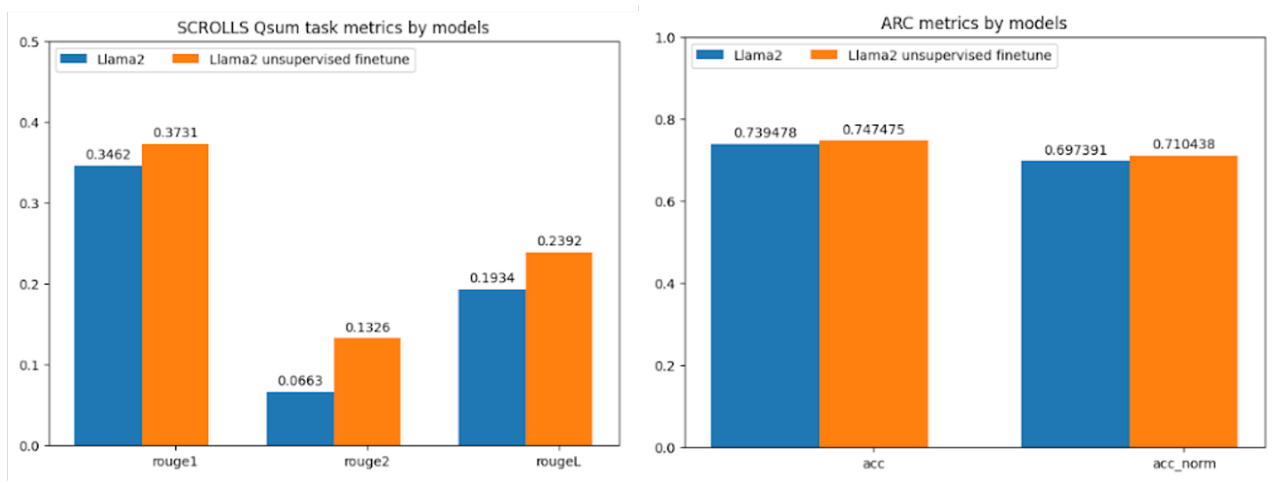

- 在标准文本摘要(SCROLLS Qsum)和中小学科学问答(ARC)基准测试中,微调模型表现优于基线模型。

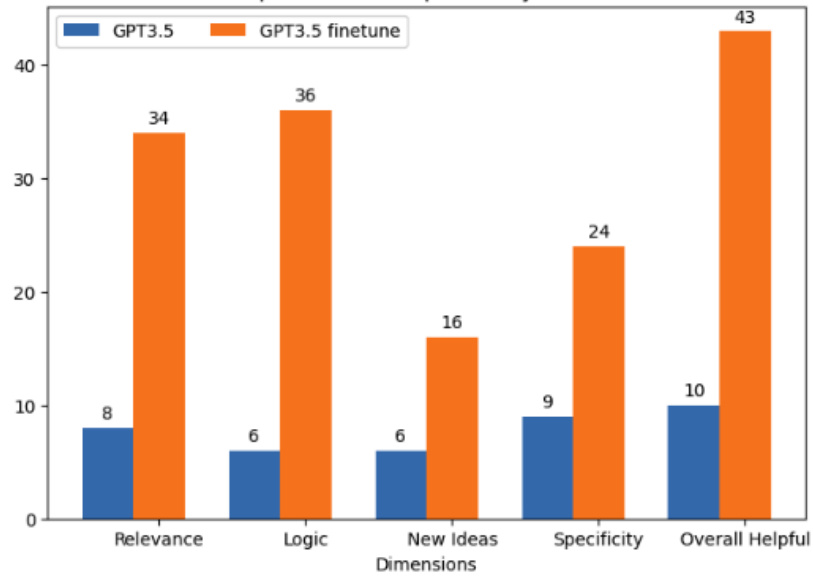

- 人工评价显示,指令微调后的GPT-3.5模型在相关性、逻辑性、新颖度、具体性和整体有用性方面均明显领先非微调版本,更贴近资深投资分析师的思考方式。

模型实际生成示例及能力提升 [page::9][page::10]

- 以“油价上涨影响行业及个股”为示例,未微调Llama2输出较笼统重复内容;微调后生成详实的行业影响分析及主要‘买入’股票名单,体现有效知识整合能力。

- GPT-3.5模型微调版回答更加简明具体且符合投资逻辑,反映专业投资观点。

结论与未来展望 [page::8]

- 基于领域数据的微调显著提升了大语言模型在投资研究任务中的表现,尤其是指令微调使GPT-3.5更像人类分析师。

- 将继续扩大训练数据范围及优化微调指令,实现更多细分投资策略的自动化生成,推动辅助投资决策的智能化发展。

深度阅读

金融研究报告详细解析:多模态生成式AI在基础投资研究中的应用

---

1. 元数据与概览

- 报告标题:Multimodal Gen-AI for Fundamental Investment Research

- 作者:Lezhi Li, Ting-Yu Chang, Hai Wang

- 机构:斯坦福大学(Stanford University)

- 发布时间:未明确给出具体日期,结合引用文献和技术背景,推测为2023年末至2024年初

- 主题:基于大型语言模型(LLMs)的金融投资决策自动化,尤其关注利用生成型AI技术提升基础投资研究的效率和质量

- 核心论点:

- 当前投资分析流程繁复,人工处理大量文档工作量大,效率低下

- 通过对开源语言模型Llama2和GPT-3.5的多种微调方法,自动生成投资总结和投资建议成为可能

- 细化的微调手段(例如LoRA低秩适配技术)加速模型在财经领域的知识融合和推理能力提升

- 项目涵盖多样化数据集,结合文本与时间序列数据,最终目标是打造AI投资助手原型,辅助人类投资者转向高价值战略分析

- 主要结论:

- 微调显著提升模型在财经领域的表现

- 基于GPT-3.5的指令微调效果尤为显著,回答更符合投资逻辑,表现更趋近于人类分析师

- Llama2虽提高了对简单查询的处理能力,但处理复杂或新颖问题依旧存在不足

---

2. 逐节深度解读

2.1 摘要与引言

报告重点介绍了利用大语言模型在财经投资领域自动化信息处理、生成投资思路的实验。任务细分为基于事件识别受影响公司和行业、理解市场条件与股价间关系、输出符合投资者喜好的投资建议和统一格式呈现结果四个目标。项目利用大量研究报告、市场新闻及时间序列数据作为训练语料,测试多种微调方法,展示了技术可行性及初步成效。

- 关键假设:基于语料的精细微调能使模型捕捉投资逻辑和推理流程

- 实验选择了Llama27bhfchat和GPT-3.5两类基模型,以此进行对比

2.2 相关工作

介绍了LLM在金融领域的应用现状,涵盖JP Morgan以大数据和机器学习驱动量化投资、以台湾研究为代表的时间序列任务微调应用、亚马逊在可解释金融预测中的开创性工作(Yu et al.[10]),以及业界典型如BloombergGPT[9]项目。区别于主要依赖公开新闻数据,报告尝试用专业机构研究报告做模型微调,突破公开信息瓶颈。

- 反映了LLM商业化应用融资研究的兴起背景

- 支持作者采用专业研究报告等独家数据集的创新路径

2.3 问题表述与数据集(章节3)

报告构建了多层次文本数据集:

| 数据类别 | 功能或内容说明 |

|-----------------|--------------------------------------------------------------------------|

| 宏观与市场报告 | 涵盖宏观经济与市场趋势,帮助模型形成宏观分析思路 |

| 行业研究报告 | 专业分析师撰写,涵盖细分行业供应链、增长、主要参与者及政策环境 |

| 个股研究报告 | 单一公司业务、盈利、管理和风险分析 |

| 投资原则 | 汇总各类研究思路,反映投资框架与哲学 |

| 市场快报 | 实时市场事件更新,呈现市场动态和专家观点 |

| 新闻 | 实时事件及其对市场的影响,强化模型对广泛市场关系的理解 |

- 其中,研究报告来自高盛等顶级券商门户,文本被转换为纯文本格式用于无监督微调

- 有监督微调结合股票当天股票价格变动作为标签,配合新闻标题

- GPT-3.5微调部分基于投资经理和分析师的问答数据,涵盖投资哲学、方法与事实知识,形成指令集

2.4 技术方法(章节4)

- 基础模型:

- Llama27bhfchat:7B参数模型,已经经过人类反馈和聊天指令微调,4-8 bit混合精度训练

- GPT-3.5-turbo:OpenAI商用模型,基于API进行指令微调

- 微调技术LoRA:

- 添加低秩权重矩阵训练,参数量小,训练效率高

- 只对Transformer中的查询(q)和值(v)投影层进行微调

- 三种微调实验:

1. 无监督微调:用GS研究报告做纯文本的下一词预测,提升领域语言建模能力

2. 有监督微调:用新闻标题对应第二天股票涨跌百分比,做分类任务,结合时序市场信息

3. 指令微调:用人工标注的Q&A格式投资指导训练GPT-3.5,提升分析师风格生成能力

2.5 无监督微调实验

- 600篇高盛研究报告爬取,内容涵盖个股、行业和宏观

- 按512 token切分,执行下一词预测

- 模型训练一个epoch,结束训练损失约为2.29

- 人工横向比较模型生成结果,微调后模型表现更合理、且没有明显事实错误

- 图2清晰展示了流程:输入研究报告文本,经过LoRA适配器训练,优化下一词预测

2.6 有监督微调实验

- 新闻标题与股票符号、对应价格做联动

- 分类标签共12个,范围从“跌超5%”到“涨超5%”,采用MSE损失编码标签

- 目前只用1000只股票样本进行训练,准确率为1.3,高于100只股票时的1

- 但预测结果全为“跌超5%”,显示训练仍不稳定,表明文本与市场价格关系尚未充分被捕捉

- 图3展示了该训练机制的结构:文本+股价涨跌标签输入模型微调

2.7 指令微调(GPT-3.5)

- 将投资哲学、方法和事实知识以Q&A指令形式整理

- 制作JSONL数据集,对GPT-3.5模型微调,使模型扮演“投资研究分析师”

- 30多个指令精心组合,取得明显的生成质量提升

- 微调模型回答更具针对性,符合投资逻辑,生成内容更合理、观点更鲜明

- 图4总结了该过程:预训练模型+指令微调→聊天模型→针对投资场景生成答复

---

3. 图表深度解读

3.1 图1(LoRA设置)

- 展示LoRA超参配置:r=4(内秩)、alpha=32(学习率相关)、dropout=0.05(正则项)

- 仅应用于transformer的查询和值投影,保证微调效率与模型安全性

- 说明对大模型进行参数高效微调的技术细节

3.2 图2(无监督微调流程)

- 流程图清晰演示了如何将GS研究报告的文本送入Llama2+LoRA进行下一词预测

- 表明所有文本被作为训练数据,模型学习领域内语言模式和投资逻辑

3.3 图3(有监督微调流程)

- 展示利用新闻标题和对应股票涨跌标签进行模型微调

- 末端设置分类头以完成涨跌幅预测任务,实现文本到时序市场变动的关联学习

3.4 图5(评测损失比较)

- 图表数据显示微调后的Llama2模型测试集困惑度降至约2.4,较基线3.07下降23%

- 表明无监督微调有效提升了模型对金融语料的语言理解和生成能力

- 困惑度下降代表模型对文本的预测精度提高,性能提升明显

3.5 图6(泛化任务表现)

- SCROLLS Qsum(摘要任务):微调模型在ROUGE-1、ROUGE-2和ROUGE-L各项指标均显著高于基线,提升幅度在10-100%之间,说明模型更擅长长文本摘要

- ARC(推理任务):准确率由约0.74提升到0.75,反映模型推理能力有所增强

- 两项任务均契合投资分析对复杂理解和逻辑推演的需求

3.6 图7(人类评价对比)

- 人类金融专家基于7个问题分别打分

- GPT-3.5微调模型在相关性(Relevance)、逻辑(Logic)、创新观点(New ideas)、具体性(Specificity)和整体帮助性(Overall Helpful)五个维度均大幅领先基线

- 总分上微调模型43分,远超基线10分,体现微调带来实际可操作的质的飞跃

---

4. 估值分析

- 本报告未具体涉及投资标的的估值模型细节(如DCF、P/E),其重点在于构建自动生成投资分析内容的语言模型框架

- 投资建议与逻辑主要通过模型微调,以捕捉领域知识和分析原则来实现,而非基于传统估值模型的数值推导

- 报告中微调后的模型通过生成更精准、有针对性的文本,间接支持投资决策流程

---

5. 风险因素评估

- 模型表现风险:

- Llama2微调模型对于复杂、未知主题仍可能生成冗长、含糊甚至无意义的内容,限制实用价值

- 有监督微调中股票涨跌预测偏差表明文本与价格的关系仍需深入挖掘,模型预期准确性有限

- 数据风险:

- 仅采集数百篇研究报告及有限股票新闻,数据规模和多样性可能不足,影响模型泛化

- 过拟合风险:

- 训练数据若重复或单一,模型可能过拟合特定表达,影响新情景下的回答质量

- 技术风险:

- LoRA微调虽然高效,但可能未能充分调优所有模型层,限制改进空间

- 投资风险:

- 模型输出还无法完全代替人类判断,若投资者过度依赖机器建议,潜藏执行风险

- 报告对风险有所提示,强调了微调带来的提升同时仍存在局限,未来需继续优化数据和模型架构

---

6. 批判性视角与细微差别

- 报告在微调效果评估主要依赖人工评分和有限公开测试,缺少大规模实盘验证,模型稳定性和可靠性仍待进一步确认

- 对有监督微调的负面结果直接披露,体现科学严谨态度,但未深入分析导致预测偏差的具体原因

- GPT-3.5微调所用指令集规模较小(约30条),未来扩大指令数量和质量可能显著提升表现

- 文本生成示例对比展示微调后文本更具体、侧重投资逻辑,而基线文本空洞且重复,说明细致微调的重要性

- 对于图表和技术介绍,解释均准确,但报告中缺乏更多定量细节(如训练时长、GPU资源消耗等),限制可复现性

- 报告适度讨论了不同模型的优缺点,保持了客观中立

---

7. 结论性综合

此份报告系统地展示了利用生成式大语言模型在基础投资研究领域的创新应用,通过无监督、监督及指令微调三个维度,结合高质量专业文本和市场数据,显著提升了模型对金融内容的理解与生成能力。

- 无监督微调:借助600篇高盛研究报告进行下一词预测,有效令Llama2模型更好捕捉金融领域语言风格及逻辑,困惑度下降23%,并在长文本摘要及基础推理任务中表现提升明显。

- 有监督微调:尝试结合新闻与股票价格变动进行分类,尽管性能尚未成熟,但表明融合文本与市场时序数据的巨大潜力。

- 指令微调(GPT-3.5):利用投资哲学与方法的问答指令训练,极大优化了模型回答的相关性、逻辑和实用性,使其回答更符合专业投资分析师的切实思考过程。

- 人工评价验证:多个维度显示微调模型较基线显著优越,而广大金融专业人士对微调后模型反应积极,尤其赞赏GPT-3.5的逻辑一致性和观点新颖度。

- 生成示例对比:以“油价上涨对行业的影响”为例,无监督微调后的模型能提供具体细分行业表现与个股推荐,较基线模型提供更切实可用的投资参考。

- 未来展望:报告建议利用更大规模和多样化数据集,结合更长指令集,进一步深化模型对细分投资策略的理解,实现生成更详细和针对性的投资建议。

整体来看,本报告证明了大规模语言模型通过针对性金融数据微调,能够跃升为具备一定投资研究能力的智能助手,极大节省人工分析时间,提升决策效率,塑造了未来智能投资研究的研究和应用蓝图。

---

附:关键图表示例展示

图5:评测集困惑度对比

- 蓝色柱代表基础Llama2模型3.07困惑度

- 橙色柱为无监督微调后2.4困惑度

- 困惑度下降表明微调使模型更好地适应金融文本分布

图6:泛化任务SCROLLS和ARC表现提升

- ROUGE指标提升,支持对长对话和复杂信息的摘要能力

- ARC推理准确率提升,表明逻辑推理能力提升

图7:人类评价维度对比(GPT-3.5基线 vs 微调)

- 所有维度微调版本均明显领先,尤其是“整体有用性”、“逻辑”和“相关性”

---

参考文献溯源

本文所有结论及释义均依据报告原文内容综合整理,引用如下页码:

- 报告引言与项目背景: [page::0], [page::1]

- 相关工作及数据集介绍:[page::1], [page::2]

- 技术方法详细说明: [page::3], [page::4], [page::5]

- 实验结果与评估:[page::6], [page::7], [page::8]

- 生成示例对比:[page::9], [page::10], [page::11], [page::12]

- 文献引用:[page::13]

---

总结:本报告系统性地阐述了如何利用开源及商业大语言模型,通过多模态微调提升基础投资研究的自动化水平。微调后的模型不仅优化了文本理解和生成的准确性,也更贴近投资决策的逻辑需求,展示了未来金融领域AI助理的重要发展方向。